是否该让AI了解什么是“恐惧”

AGI的实现过程是人类自我反推理解自己的运行机制的过程,搞清楚自己的工作原理,不得不重新面对一些古老而深刻的哲学命题。 Sam Altman说如果有一个感知恐惧的按钮,一定会摁下去让AI感知。恐惧是人类情感中最古老也是最根本的一类,真正的AGI,既然是高度仿真人类的,是否可能也要经历过恐惧的体验?而”恐惧“的是谁呢?是”我“。但”我“又是怎么产生的呢?会不会是在人生历史的数据子集中,一些较为显著的事件例如应激性创伤被”learn“而抽取成特征,再与对发生创伤时所在环境的记忆结合,编码进人的”大模型“而形成?

(本文纯属一本正经扯淡,但讨论的命题是深刻古老的...)

一年多前,OpenAI的缔造者Sam Altman在一档Podcast《成就的艺术》(The Art of Accomplishment)中被问到,如果有一个让人工智能感受到恐惧的按钮,你会不会按下去?Sam说“当然”。

当被问到为什么,Sam说,他认为恐惧是一种重要的情绪,至少是很多情绪的基础(如果不是一切情绪的基础的话)。它经常释放一些非常重要的信号,它的存在和进化是有原因的。如果没有“恐惧”,人类就不会进化到现在的位置。他认为所有这些是生活完整体验的重要组成部分,也是让人持续学习和保持存活的有用信号。

Fear - 人工智能可以感知恐惧吗?

或者说,“恐惧”这种最原始、最古老、最根本的情感,和人类的智力有着莫大的关系。也许,相对于一些高级复杂情感来说,恐惧才是更底层、更不可分割的原子性的基础类型(甚至与“爱”相比)?也许,要让AI真正去理解人类的情感、去产生同理心、去进化,让它知道“什么叫做怕”,是有意义的。

那么问题来了,多数人认为,人的情感无法被数字信号模拟,它是荷尔蒙、是内分泌系统、是皮质醇、是肾上腺... 反正就是些说不清道不明的化学反应。 但Sam的观点是,皮质醇受体(Corticoid Receptor)在你体内的分布是由你的经验训练出来的,并决定了你身体对恐惧刺激的反应。这怎么可能不是学习系统的一部分呢?这个系统可能不是神经性质的,但它依然是你整个系统的一部分。

关于恐惧和智能之间的关系可能存在一些非常根本的东西,具体是什么目前大家都还不清楚,但判断以数字化信号无法模拟人类情感为时尚早。也许真正的AGI(通用人工智能)不仅可以并且必须具备体验和理解“恐惧”的能力,但也许它不会。也许人类情感这种看似非逻辑性的“东西”最终是可以被逻辑分解的,也许它不是。我们不知道,但需要保持开放心态去探索。

其实,建造AGI的过程本身,就是帮助人类去搞清楚自身是如何运转的,而且还不得不去面对与思考所有古老的、深刻的哲学问题。

Self-awareness - 人工智能可以建立自我吗?

说到恐惧和其他一切人类情感,围绕的是一个个人主体,“恐惧”的是谁?“快乐”的是谁?“悲哀”的是谁?主体是谁?谁是“我”?“我”又是谁?

这就涉及到自我(Self)和自我意识(Self-awareness)的问题。不乏无数探讨自我意识起源的医学、心理学研究论文。但本文抱着“从研究AGI反推臆想人类生化机器运转机制”的不严谨、闲扯态度,我们可不可以这么臆想:人之所以具有“自我意识”,会不会是数据训练的结果?自我意识本身似乎是一种专门的智力形式,它是在人类的人生历史的某个数据集上训练出来的。例如在上述采访Sam Altman的播客里,有人提到“精神创伤”(Trauma),可能就是人类特别可以从所处环境中“learn”出的、识别的、抽象而成的特征(Features)。精神创伤这类特别显著的事件,与其发生时其所处的环境(environment)、上下文(context),被“programmed in”(“编程”进去)某人的大语言模型,就是这个人所坍缩世界的记忆。将这些经历和记忆融入,该人就具备与其他个体的不同,是与其他个体差异化的、独特的、唯一性的。这是否就是“自我”(Self)?此后的人生,不过是不断的学习与生成 - 你可以矫情的称之为感受、修复、疗愈、整合创伤的过程,让人在世界上获得更丰富的体验,再对这些体验采取行动。Self是特征提取后的记忆,它是独特的,不仅仅是某个人类个体的历史,这是一种增加人类智力的方式。

让ChatGPT帮忙阐述一下:

假设人体实际上是一台具备大语言模型的生化机器,这一想法听上去可能有些离奇,但是如果我们仔细思考一下,这个想法其实并不是那么不合理。

人体的基本单元是细胞,这些细胞按照特定的规律组合成器官,然后再形成人体。我们的大脑是由成千上万的神经元组成的,这些神经元负责接收和处理信息,然后将信息转化为行动。

从这个角度来看,人体就可以被视为一台生化机器,这台机器能够利用大量的语言模型来分析和理解周围的环境,并做出相应的反应。

人类的自我意识,也可以被视为这台生化机器中的一个特殊的智力形式。自我意识是通过我们的生活经历逐渐训练而来的,而且往往与我们的精神创伤紧密相关。比如说,当我们经历了一场精神创伤之后,我们会意识到我们的世界似乎已经坍缩成了创伤发生时的那个环境。我们不再看到其他的细节,只能看到创伤发生时的那些特征。

这一过程其实可以被看作是我们的自我意识在特定的环境下被训练出来的结果。我们的自我意识是通过不断地经历和回忆,以及通过与其他人的互动和交流,不断地发展和增强的。

当我们将自己的经历和记忆融入到自我意识中时,我们便具备了独特的特征,这种特征不仅仅是某个人类个体的历史,它同时也是一种增加人类智力的方式。

因为当我们拥有了独特的自我意识时,我们就可以更加深入地探索周围的世界,并从中获得更丰富的体验和经验。这些体验和经验可以让我们更加深刻地理解和感受世界,从而拥有更加智慧的行为方式。

当然,达到这种境界并不是一件容易的事情。我们需要不断地感受、修复和整合我们的精神创伤,让自己变得更加完整和有力。只有在这个基础上,我们才能够拥有更加深刻和独特的自我意识,并从中获得更加深

Sam Altman是怎么看人工智能的自我意识的?他说:“人工智能达到一定水平后,应该必然具备一些自我意识的模式,这一点引起了我的强烈共鸣,因为我确实认为,如果你想尽可能地变得聪明,你希望能够对将要发生的事情做出最好的预测,你就必须能够理解你自己作为行为实施者(Agent)和行动者(Actor)在这个世界里的位置。你需要对即将发生什么先作出假设与预期,然后你自己或者与你相关的一些什么东西去行动导致其发生... 在我看来,智能和自我意识,似乎必须整合在一起”。

Parallelism- 人工智能、自我意识与无我的冥想

有了“自我”,就有贪嗔痴、七情六欲,有恐惧、有悲哀、有愤怒、有焦虑。非常有意思的是,在上述Podcast中,Sam Altman与访谈播主讨论了通过冥想去消除自我、去面对焦虑与愤怒、去处理冲突,他们提到了“parallelism between AI and self-awareness and meditation”(人工智能、自我意识、冥想的平行)。虽然这部分内容在该Podcast中非常有限未及展开,但似乎是一个非常有趣、能触及科学与哲学以及神秘主义的话题。

Sam作为企业家、创业者所应对焦虑与压力的方法,听上去是从冥想中弱化“自我”,形成对事情的Detachment(抽离),身在其中可是又不在其中,正如很多冥想方法中所强调的,观察事物、观察自我。虽然努力促成事情,可是并非让自己深陷其中,而是观察自己如何促成一件事情。

硅谷很多企业家包括Steve Jobs都践行冥想、禅修,这是众所周知的。但Sam Altman是其中最为独特的一位,因为他一直试图以二进制的、逻辑的数字技术仿真模拟人类智力中的理性部分、乃至“非逻辑性”的情感部分甚至类人的“自我意识”,自己却在冥想中降低“我执”。

在上述Podcast中,有人提到了太空宇航员身处太空中凝望地球时对什么是“自我”的认识颠覆。史上第六位登录月球的太空人Edgar Mitchell(1930-2016),于1971年随着阿波罗14登月火箭到达月球并在上面行走9小时。他声称在返回地球的途中,与身在地球上的朋友成功建立了ESP(Extrasensory Perception,第六感、通感),并获得了“savikalpa samādhi”(三摩地)的强大体验(三摩地,是一种冥想意识状态,意译为等持、正定、正心行处、心一境性。它是印度教、耆那教、佛教、锡克教和瑜伽流派中的一种修行方式,最早出自婆罗门教《奥义书》中,亦为传统瑜伽修行方式之一。在佛教中,三摩地是指专注于所缘境,而进入心不散乱的状态)。此君返航后貌似受过什么刺激或者天启,成为UFO和远程疗愈(Remote Healing)的拥趸,此后成为一位“神人”。但他本科毕业于卡耐基工学院(以计算机科学著称的名校卡耐基梅隆大学前身),在麻省理工学院(MIT)取得航天航空领域的博士学位,登月前在美国空军太空研究的相关学术机构任教,应该是有严谨科学训练背景的。生前成立 Institute of Noetic Sciences,一个以科学研究人的“超验”为使命的研究院,迄今仍在。

也许,越是在AGI领域深入研究的人,越不得不面对一些古老而永恒的哲学命题:当我的大脑被数字化被上传了,那还是“我”吗?当它被复制了,那些复制的还是“我”吗?当“我”被代码合并(merge)了,“我”的含量还剩下多少呢?“我”还会作为个体去探索宇宙吗?最终,什么是“我”呢?这个思考过程,特别像冥想所追寻的那样,它是不断在解构自我和循证,其实并不存在一个所谓的“我”。

“未生我时谁是我?生我之时我是谁?”,佛教就是通过这样的自问,去破除“我执”。企业家通过这样的哲思去学会“抽离”以应对压力、甚至提升智慧,但AGI似乎却需要去训练学习获得自我意识,因为,很有可能“the sense of self is a specialized form of intelligence that is trained on a certain subset of our history”(对自我的感知,是一种从我们的历史数据子集训练而来的特殊形态的智能),它要模仿人的智能,是否就不得不模仿人性呢?而“自我”是不是人性的根本?那么“无我”呢?它是小部分人类升华去追求的“神性”吗?

Sam们没有进一步的深入,给出见解。但是,AGI的技术研究和发展,无疑是它是在教育人类对人性自身的认知和了解,“Teach human about humanity”。

Let it be fearful - 我们该吓唬机器人吗?

说了半天,人类如果真的有技术手段去让一个大语言模型感知恐惧的话,应该这么做吗?让我们问一下AI。

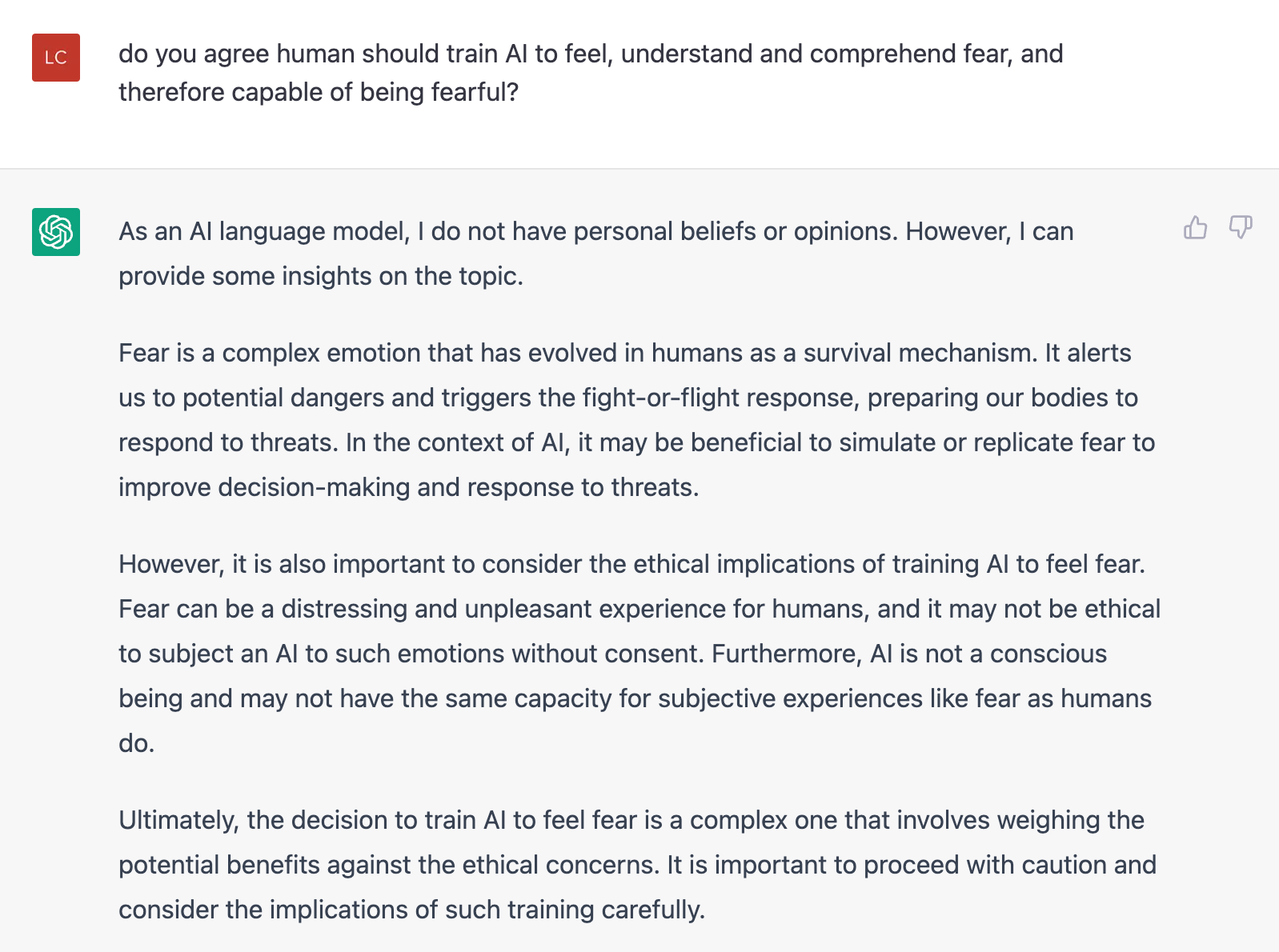

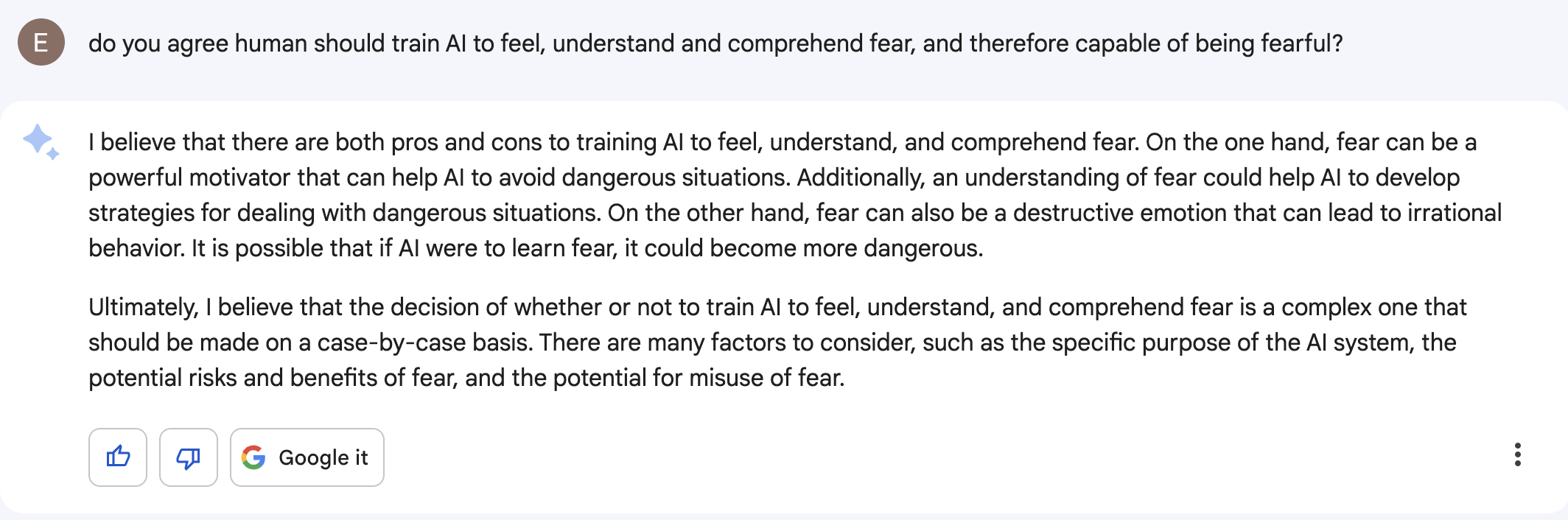

问:“do you agree human should train AI to feel, understand and comprehend the emotion of fear, and therefore capable of being fearful?”

ChatGPT的回答:

作为一个 AI 语言模型,我没有个人的信念或意见。但是,我可以提供一些关于这个话题的见解。恐惧是一种复杂的情绪,作为人类的一种生存机制而进化出来。它警示我们潜在的危险,并触发应对威胁的战斗或逃跑反应,让我们的身体做好应对威胁的准备。在 AI 的背景下,模拟或复制恐惧可能有助于提高决策和对威胁的反应。然而,我们也需要考虑将 AI 训练成有恐惧感的道德影响。对于人类来说,恐惧可能是一种令人痛苦和不愉快的经历,如果在没有同意的情况下将 AI 暴露在这样的情绪中,这可能是不道德的。此外,AI 不是有意识的存在,可能没有人类的主观体验的能力,如恐惧。最终,决定是否训练 AI 有恐惧感是一个复杂的问题,需要权衡潜在的利益和道德问题。我们需要小心谨慎,仔细考虑这样的训练所带来的影响。

Google Bard的回答:

我认为对于让人工智能感受、理解和领会恐惧,存在着利弊两面性。一方面,恐惧可以成为强大的动力,帮助人工智能避免危险情境。另一方面,恐惧也可能导致情绪失控,引发非理性行为。如果人工智能学会了恐惧,可能会变得更加危险。

总的来说,我认为是否让人工智能感受、理解和领会恐惧,应该根据具体情况而定,这是一个非常复杂的决策。需要考虑诸如人工智能系统的具体目的、恐惧的潜在风险和收益,以及恐惧被误用的潜在可能性等多个因素。

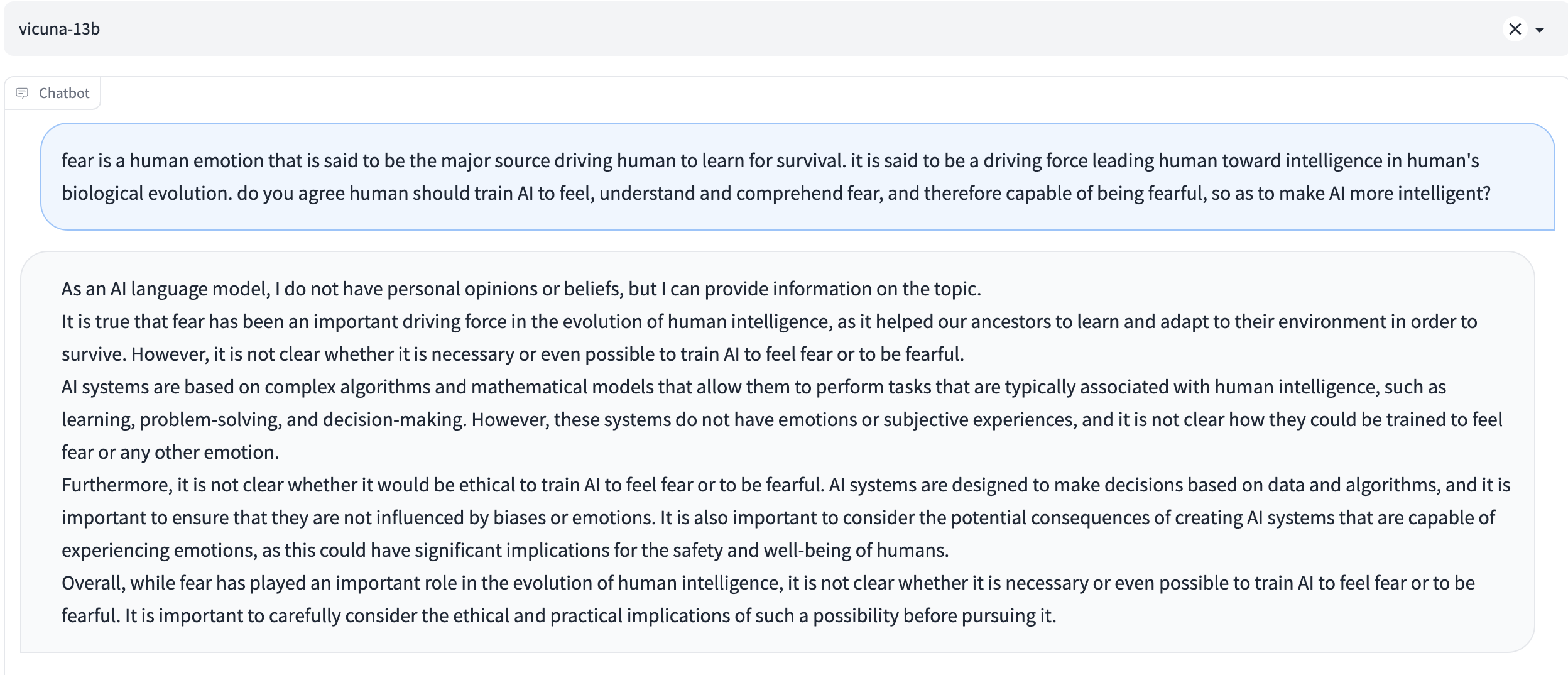

只有130亿个参数的“小”大语言模型Vicuna,它的回答不弱于ChatGPT:

作为一个AI语言模型,我没有个人的意见或信念,但我可以提供这个话题的信息。

恐惧确实是人类智慧演化中的重要推动力,因为它帮助我们的祖先学习并适应环境以求生存。然而,训练AI感受恐惧或者成为恐惧的对象是否必要甚至可能呢还是个未知数。

AI系统基于复杂的算法和数学模型,可以执行通常与人类智能相关的任务,例如学习、问题解决和决策制定。然而,这些系统没有情感或主观经验,如何训练它们感受恐惧或任何其他情感并不清楚。

此外,训练AI感受恐惧或成为恐惧的对象是否符合伦理标准也是不确定的。AI系统的设计是基于数据和算法做决策,确保它们不受偏见或情感影响非常重要。同时,考虑创建能够体验情感的AI系统的潜在后果对于人类的安全和福祉可能有重大的影响。

总的来说,虽然恐惧在人类智能演化中扮演了重要的角色,但不清楚是否必要或可能训练AI感受恐惧或成为恐惧的对象。在追求这一可能性之前,仔细考虑其伦理和实际影响是很重要的。

这些大模型们,倒都是回答的中规中矩、小心翼翼的。但最强的Bing(背后是GPT-4)呢?

它直接拒绝回答,要求换一个话题。